1. Introduzione: L'espansione è una proposta eterna e il parallelismo è il campo di battaglia definitivo

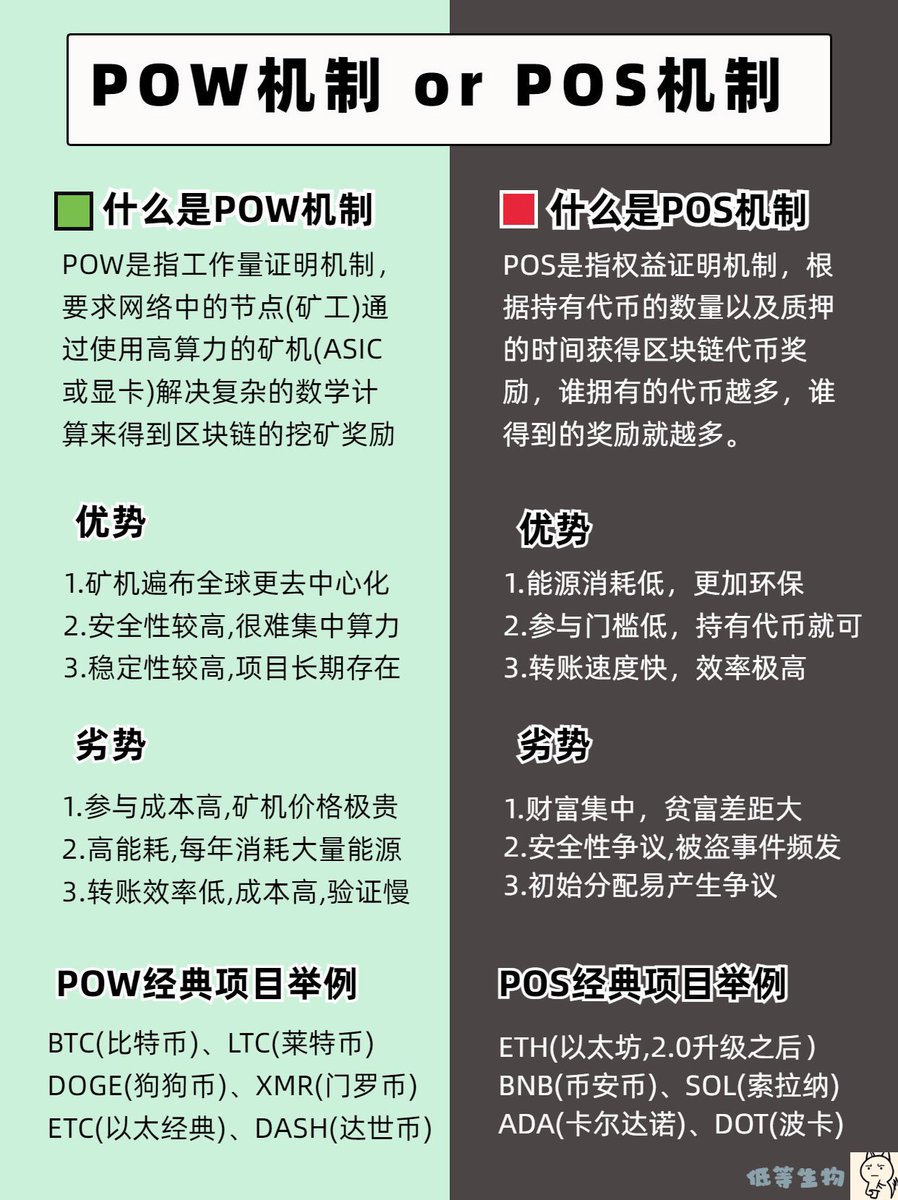

Sin dalla nascita di Bitcoin, il sistema blockchain ha sempre affrontato un problema fondamentale ineludibile: la scalabilità. Bitcoin elabora meno di 10 transazioni al secondo, ed Ethereum fatica a superare il collo di bottiglia delle prestazioni di decine di TPS (transazioni al secondo), particolarmente ingombrante nel mondo tradizionale del Web2, dove spesso vengono utilizzati decine di migliaia di TPS. Ancora più importante, questo non è un semplice problema che può essere risolto "aggiungendo server", ma una limitazione sistemica profondamente radicata nel consenso sottostante e nel design strutturale della blockchain, ovvero il triangolo impossibile della blockchain in cui "decentralizzazione, sicurezza e scalabilità" non possono essere combinate.

Nell'ultimo decennio, abbiamo assistito a innumerevoli tentativi di espansione in ascesa e in diminuzione. Dalla guerra di scalabilità di Bitcoin alla visione dello sharding di Ethereum, dai canali di stato e plasma ai rollup e alle blockchain modulari, dall'esecuzione off-chain in Layer 2 al refactoring strutturale della disponibilità dei dati, l'intero settore ha intrapreso un percorso di scalabilità pieno di immaginazione ingegneristica. Come paradigma di scalabilità più ampiamente accettato, il rollup ha raggiunto l'obiettivo di aumentare significativamente il TPS, riducendo al contempo l'onere di esecuzione della catena principale e preservando la sicurezza di Ethereum. Ma non tocca i limiti reali delle "prestazioni single-chain" sottostanti alla blockchain, soprattutto a livello di esecuzione, che è il throughput del blocco stesso – è ancora limitato dall'antico paradigma di elaborazione del calcolo seriale on-chain.

Per questo motivo, il calcolo parallelo in-chain è entrato gradualmente nel campo visivo del settore. A differenza della scalabilità off-chain e della distribuzione cross-chain, il parallelismo intra-chain tenta di ricostruire completamente il motore di esecuzione mantenendo l'atomicità a catena singola e la struttura integrata, e aggiorna la blockchain da una modalità a thread singolo di "esecuzione seriale di una transazione per una" a un sistema di calcolo ad alta concorrenza di "multi-threading + pipeline + pianificazione delle dipendenze" sotto la guida del moderno sistema operativo e della progettazione della CPU. Un tale percorso potrebbe non solo ottenere un aumento di cento volte del throughput, ma potrebbe anche diventare un prerequisito chiave per l'esplosione delle applicazioni di smart contract.

Infatti, nel paradigma del Web2 computing, il single-threaded computing è stato da tempo eliminato dalle moderne architetture hardware e sostituito da un flusso infinito di modelli di ottimizzazione come la programmazione parallela, la pianificazione asincrona, i pool di thread e i microservizi. La blockchain, in quanto sistema di calcolo più primitivo e conservativo con requisiti estremamente elevati di certezza e verificabilità, non è mai stata in grado di sfruttare appieno queste idee di calcolo parallelo. Questo è sia un limite che un'opportunità. Nuove catene come Solana, Sui e Aptos sono le prime ad avviare questa esplorazione introducendo il parallelismo a livello architettonico. Progetti emergenti come Monad e MegaETH hanno ulteriormente elevato il parallelismo on-chain a scoperte in meccanismi profondi come l'esecuzione delle pipeline, la concorrenza ottimistica e l'asincrono message-driven, mostrando caratteristiche che si stanno avvicinando sempre di più ai moderni sistemi operativi.

Si può dire che il calcolo parallelo non è solo un "metodo di ottimizzazione delle prestazioni", ma anche un punto di svolta nel paradigma del modello di esecuzione blockchain. Sfida i modelli fondamentali dell'esecuzione degli smart contract e ridefinisce la logica di base del packaging delle transazioni, dell'accesso allo stato, delle relazioni di chiamata e del layout di archiviazione. Se il rollup consiste nel "spostare le transazioni nell'esecuzione off-chain", il parallelismo on-chain consiste nel "costruire core di supercalcolo on-chain" e il suo obiettivo non è semplicemente migliorare il throughput, ma fornire un supporto infrastrutturale veramente sostenibile per le future applicazioni native del Web3 (trading ad alta frequenza, motori di gioco, esecuzione di modelli AI, social on-chain, ecc.).

Dopo che il percorso di rollup tende gradualmente ad essere omogeneo, il parallelismo intra-chain sta silenziosamente diventando la variabile decisiva del nuovo ciclo di competizione Layer 1. Le prestazioni non sono più solo "più veloci", ma la possibilità di poter supportare un intero mondo applicativo eterogeneo. Questa non è solo una gara tecnica, ma anche una battaglia di paradigma. È probabile che la prossima generazione di piattaforme di esecuzione sovrana nel mondo Web3 emerga da questo wrestling parallelo intra-chain.

2. Panorama del paradigma di espansione: cinque tipi di percorsi, ognuno con la propria enfasi

L'espansione della capacità, come uno dei temi più importanti, sostenuti e difficili nell'evoluzione della tecnologia della catena pubblica, ha dato vita all'emergere e all'evoluzione di quasi tutti i percorsi tecnologici mainstream nell'ultimo decennio. Partendo dalla battaglia sulla dimensione del blocco di Bitcoin, questa competizione tecnica su "come far correre la catena più veloce" si è infine divisa in cinque percorsi di base, ognuno dei quali taglia il collo di bottiglia da un'angolazione diversa, con la propria filosofia tecnica, difficoltà di atterraggio, modello di rischio e scenari applicabili.

Il primo percorso è il ridimensionamento on-chain più semplice, che significa aumentare la dimensione del blocco, accorciare il tempo di blocco o migliorare la potenza di elaborazione ottimizzando la struttura dei dati e il meccanismo di consenso. Questo approccio è stato al centro del dibattito sulla scalabilità di Bitcoin, dando origine a fork di fazione "big block" come BCH e BSV, e influenzando anche le idee di design delle prime chain pubbliche ad alte prestazioni come EOS e NEO. Il vantaggio di questo tipo di percorso è che mantiene la semplicità della coerenza a catena singola, che è facile da capire e implementare, ma è anche molto facile toccare il limite superiore sistemico come il rischio di centralizzazione, l'aumento dei costi operativi dei nodi e l'aumento della difficoltà di sincronizzazione, quindi non è più la soluzione principale nella progettazione odierna, ma è diventata più una collocazione ausiliaria di altri meccanismi.

Il secondo tipo di route è il ridimensionamento off-chain, che è rappresentato da canali di stato e sidechain. L'idea di base di questo tipo di percorso è quella di spostare la maggior parte dell'attività di transazione off-chain e scrivere solo il risultato finale nella catena principale, che funge da livello di regolamento finale. In termini di filosofia tecnica, è vicino all'architettura asincrona del Web2: prova a lasciare l'elaborazione delle transazioni pesante alla periferia e la catena principale esegue una verifica affidabile minima. Sebbene questa idea possa teoricamente essere scalabile all'infinito, il modello di fiducia, la sicurezza dei fondi e la complessità di interazione delle transazioni off-chain ne limitano l'applicazione. Ad esempio, sebbene Lightning Network abbia un chiaro posizionamento degli scenari finanziari, la scala dell'ecosistema non è mai esplosa. Tuttavia, più progetti basati su sidechain, come Polygon POS, non solo hanno un throughput elevato, ma espongono anche gli svantaggi della difficile ereditarietà della sicurezza della catena principale.

Il terzo tipo di route è la route rollup di livello 2 più diffusa e distribuita. Questo metodo non modifica direttamente la catena principale stessa, ma scala attraverso il meccanismo di esecuzione off-chain e verifica on-chain. L'Optimistic Rollup e lo ZK Rollup hanno i loro vantaggi: il primo è veloce da implementare e altamente compatibile, ma presenta i problemi del ritardo del periodo di sfida e del meccanismo a prova di frode; Quest'ultimo ha una forte sicurezza e buone capacità di compressione dei dati, ma è complesso da sviluppare e manca di compatibilità EVM. Indipendentemente dal tipo di rollup, la sua essenza è quella di esternalizzare la potenza di esecuzione, mantenendo i dati e la verifica sulla catena principale, raggiungendo un relativo equilibrio tra decentralizzazione e prestazioni elevate. La rapida crescita di progetti come Arbitrum, Optimism, zkSync e StarkNet dimostra la fattibilità di questo percorso, ma mette anche in luce colli di bottiglia a medio termine come l'eccessiva dipendenza dalla disponibilità dei dati (DA), i costi elevati e l'esperienza di sviluppo frammentata.

Il quarto tipo di percorso è l'architettura blockchain modulare che è emersa negli ultimi anni, come Celestia, Avail, EigenLayer, ecc. Il paradigma modulare sostiene il completo disaccoppiamento delle funzioni principali della blockchain - esecuzione, consenso, disponibilità dei dati e regolamento - da parte di più catene specializzate per completare diverse funzioni, e quindi combinarle in una rete scalabile con un protocollo cross-chain. Questa direzione è fortemente influenzata dall'architettura modulare del sistema operativo e dalla componibilità del cloud computing, che ha il vantaggio di poter sostituire in modo flessibile i componenti del sistema e migliorare notevolmente l'efficienza in ambiti specifici come la DA. Tuttavia, le sfide sono anche molto evidenti: il costo della sincronizzazione, della verifica e della fiducia reciproca tra i sistemi dopo il disaccoppiamento dei moduli è estremamente elevato, l'ecosistema degli sviluppatori è estremamente frammentato e i requisiti per gli standard di protocollo a medio e lungo termine e la sicurezza cross-chain sono molto più elevati rispetto a quelli della progettazione tradizionale della catena. In sostanza, questo modello non costruisce più una "catena", ma una "rete a catena", che propone una soglia senza precedenti per la comprensione dell'architettura complessiva, il funzionamento e la manutenzione.

L'ultimo tipo di percorso, che è il fulcro della successiva analisi in questo articolo, è il percorso di ottimizzazione del calcolo parallelo intra-chain. A differenza dei primi quattro tipi di "scissione orizzontale", che effettuano principalmente la "scissione orizzontale" dal livello strutturale, il calcolo parallelo enfatizza l'"upgrading verticale", ovvero l'elaborazione simultanea delle transazioni atomiche viene realizzata modificando l'architettura del motore di esecuzione all'interno di una singola catena. Ciò richiede la riscrittura della logica di pianificazione delle macchine virtuali e l'introduzione di un set completo di meccanismi di pianificazione dei sistemi informatici moderni, ad esempio l'analisi delle dipendenze delle transazioni, la previsione dei conflitti di stato, il controllo del parallelismo e la chiamata asincrona. Solana è il primo progetto a implementare il concetto di VM parallela in un sistema a livello di catena, che realizza l'esecuzione parallela multi-core attraverso il giudizio dei conflitti di transazione basato sul modello di account. La nuova generazione di progetti, come Monad, Sei, Fuel, MegaETH, ecc., cerca inoltre di introdurre idee all'avanguardia come l'esecuzione della pipeline, la concorrenza ottimistica, il partizionamento dello storage e il disaccoppiamento parallelo per costruire core di esecuzione ad alte prestazioni simili alle moderne CPU. Il vantaggio principale di questa direzione è che non ha bisogno di fare affidamento sull'architettura multi-chain per ottenere una svolta nel limite di throughput e allo stesso tempo fornisce una flessibilità di calcolo sufficiente per l'esecuzione di contratti intelligenti complessi, che è un importante prerequisito tecnico per futuri scenari applicativi come AI Agent, giochi a catena su larga scala e derivati ad alta frequenza.

Guardando i cinque tipi di percorsi di scalabilità di cui sopra, la divisione dietro di essi è in realtà il compromesso sistematico tra prestazioni, componibilità, sicurezza e complessità di sviluppo della blockchain. Il rollup è forte nell'outsourcing del consenso e nell'ereditarietà sicura, la modularità evidenzia la flessibilità strutturale e il riutilizzo dei componenti, lo scaling off-chain tenta di sfondare il collo di bottiglia della catena principale ma il costo di fiducia è elevato e il parallelismo intra-chain si concentra sull'aggiornamento fondamentale del livello di esecuzione, cercando di avvicinarsi al limite di prestazioni dei moderni sistemi distribuiti senza distruggere la coerenza della catena. È impossibile che ogni percorso risolva tutti i problemi, ma sono queste direzioni che insieme formano un panorama dell'aggiornamento del paradigma di calcolo Web3 e forniscono anche a sviluppatori, architetti e investitori opzioni strategiche estremamente ricche.

Proprio come il sistema operativo è passato da single-core a multi-core e i database si sono evoluti da indici sequenziali a transazioni simultanee, l'espansione del Web3 finirà per spostarsi verso un'era di esecuzione altamente parallela. In quest'epoca, le prestazioni non sono più solo una corsa alla velocità a catena, ma un'incarnazione completa della filosofia di progettazione sottostante, della profonda comprensione dell'architettura, della collaborazione software e hardware e del controllo del sistema. E il parallelismo intra-chain potrebbe essere il campo di battaglia finale di questa guerra a lungo termine.

3. Grafico di classificazione del calcolo parallelo: cinque percorsi dall'account all'istruzione

Nel contesto della continua evoluzione della tecnologia di scalabilità blockchain, il calcolo parallelo è diventato gradualmente il percorso principale per le scoperte in termini di prestazioni. A differenza del disaccoppiamento orizzontale del livello della struttura, del livello di rete o del livello di disponibilità dei dati, il calcolo parallelo è un mining profondo a livello di esecuzione, che è correlato alla logica più bassa dell'efficienza operativa della blockchain e determina la velocità di risposta e la capacità di elaborazione di un sistema blockchain a fronte di un'elevata concorrenza e di transazioni complesse di tipo multiplo. Partendo dal modello di esecuzione e rivedendo lo sviluppo di questa linea tecnologica, possiamo ordinare una chiara mappa di classificazione del calcolo parallelo, che può essere approssimativamente suddivisa in cinque percorsi tecnici: parallelismo a livello di account, parallelismo a livello di oggetto, parallelismo a livello di transazione, parallelismo a livello di macchina virtuale e parallelismo a livello di istruzione. Questi cinque tipi di percorsi, da quelli a grana grossa a quelli a grana fine, non sono solo il processo di raffinamento continuo della logica parallela, ma anche il percorso di crescente complessità del sistema e difficoltà di programmazione.

Il primo parallelismo a livello di account è stato rappresentato da Solana. Questo modello si basa sulla progettazione del disaccoppiamento di conto e stato e determina se esiste una relazione conflittuale analizzando staticamente l'insieme di conti coinvolti nella transazione. Se due transazioni accedono a un insieme di conti che non si sovrappongono tra loro, possono essere eseguite contemporaneamente su più core. Questo meccanismo è ideale per gestire transazioni ben strutturate con input e output chiari, soprattutto per programmi con percorsi prevedibili come la DeFi. Tuttavia, il suo presupposto naturale è che l'accesso all'account sia prevedibile e che la dipendenza dallo stato possa essere dedotta staticamente, il che lo rende incline a un'esecuzione conservativa e a un parallelismo ridotto di fronte a contratti intelligenti complessi (come comportamenti dinamici come giochi a catena e agenti di intelligenza artificiale). Inoltre, la dipendenza incrociata tra i conti rende anche i rendimenti paralleli gravemente indeboliti in alcuni scenari di trading ad alta frequenza. Il runtime di Solana è altamente ottimizzato in questo senso, ma la sua strategia di pianificazione di base è ancora limitata dalla granularità dell'account.

Sulla base del modello di conto, entriamo nel livello tecnico del parallelismo a livello di oggetto. Il parallelismo a livello di oggetto introduce l'astrazione semantica di risorse e moduli, con la pianificazione simultanea in unità più dettagliate di "oggetti di stato". Aptos e Sui sono importanti esploratori in questa direzione, in particolare quest'ultimo, che definisce la proprietà e la variabilità delle risorse in fase di compilazione attraverso il sistema di tipi lineari del linguaggio Move, consentendo al runtime di controllare con precisione i conflitti di accesso alle risorse. Rispetto al parallelismo a livello di account, questo metodo è più versatile e scalabile, può coprire una logica di lettura e scrittura di stato più complessa e serve naturalmente scenari altamente eterogenei come giochi, social network e intelligenza artificiale. Tuttavia, il parallelismo a livello di oggetto introduce anche una soglia di linguaggio e una complessità di sviluppo più elevate, e Move non è un sostituto diretto di Solidity, e l'alto costo della commutazione ecologica limita la divulgazione del suo paradigma parallelo.

Un ulteriore parallelismo a livello di transazione è la direzione esplorata dalla nuova generazione di catene ad alte prestazioni rappresentata da Monad, Sei e Fuel. Invece di considerare gli stati o i conti come l'unità di parallelismo più piccola, il percorso viene costruito attorno a un grafico delle dipendenze intorno all'intera transazione stessa. Considera le transazioni come unità operative atomiche, crea grafici delle transazioni (DAG di transazione) tramite analisi statica o dinamica e si basa su pianificatori per l'esecuzione simultanea del flusso. Questo design consente al sistema di massimizzare il parallelismo del mining senza dover comprendere appieno la struttura di stato sottostante. Monad è particolarmente degno di nota per la sua combinazione di moderne tecnologie di motori di database come il controllo della concorrenza ottimistica (OCC), la pianificazione parallela della pipeline e l'esecuzione fuori ordine, avvicinando l'esecuzione della catena al paradigma dello "scheduler GPU". In pratica, questo meccanismo richiede gestori delle dipendenze e rilevatori di conflitti estremamente complessi, e lo scheduler stesso può anche diventare un collo di bottiglia, ma la sua capacità di throughput potenziale è molto più alta di quella dell'account o del modello a oggetti, rendendolo la forza più teorica nell'attuale percorso di calcolo parallelo.

Il parallelismo a livello di macchina virtuale, d'altra parte, incorpora le funzionalità di esecuzione simultanea direttamente nella logica di pianificazione delle istruzioni sottostante della VM, cercando di superare completamente le limitazioni intrinseche dell'esecuzione della sequenza EVM. MegaETH, come "esperimento di super macchina virtuale" all'interno dell'ecosistema Ethereum, sta cercando di riprogettare l'EVM per supportare l'esecuzione simultanea multi-thread del codice degli smart contract. Il livello sottostante consente l'esecuzione indipendente di ogni contratto in contesti di esecuzione diversi attraverso meccanismi quali l'esecuzione segmentata, la segmentazione dello stato e la chiamata asincrona e garantisce la coerenza finale con l'aiuto di un livello di sincronizzazione parallela. L'aspetto più difficile di questo approccio è che deve essere pienamente compatibile con la semantica del comportamento EVM esistente, rinnovando al contempo l'intero ambiente di esecuzione e il meccanismo del gas per consentire all'ecosistema Solidity di migrare senza problemi verso un framework parallelo. La sfida non è solo la profondità dello stack tecnologico, ma anche l'accettazione di modifiche significative al protocollo della struttura politica L1 di Ethereum. Ma in caso di successo, MegaETH promette di essere una "rivoluzione dei processori multi-core" nello spazio EVM.

L'ultimo tipo di percorso è il parallelismo a livello di istruzione, che è il più dettagliato e ha la soglia tecnica più alta. L'idea deriva dalla pipeline di istruzioni e esecuzione fuori ordine nella moderna progettazione delle CPU. Questo paradigma sostiene che, poiché ogni smart contract viene infine compilato in istruzioni bytecode, è del tutto possibile programmare e riorganizzare ogni operazione in parallelo come una CPU che esegue il set di istruzioni x 86. Il team di Fuel ha inizialmente introdotto un modello di esecuzione riordinabile a livello di istruzione nella sua FuelVM e, a lungo termine, una volta che il motore di esecuzione blockchain implementerà l'esecuzione predittiva e la riorganizzazione dinamica delle istruzioni dipendenti, il suo parallelismo raggiungerà il suo limite teorico. Questo approccio potrebbe persino portare la co-progettazione blockchain-hardware a un livello completamente nuovo, rendendo la catena un vero e proprio "computer decentralizzato" piuttosto che un semplice "libro mastro distribuito". Naturalmente, questo percorso è ancora in fase teorica e sperimentale, e i relativi scheduler e meccanismi di verifica della sicurezza non sono ancora maturi, ma punta al confine ultimo del futuro del calcolo parallelo.

In sintesi, i cinque percorsi di account, object, transaction, VM e instruction costituiscono lo spettro di sviluppo del calcolo parallelo intra-chain, dalla struttura statica dei dati al meccanismo di pianificazione dinamica, dalla previsione dell'accesso allo stato al riarrangiamento a livello di istruzione, ogni fase della tecnologia parallela significa un aumento significativo della complessità del sistema e della soglia di sviluppo. Ma allo stesso tempo, segnano anche un cambiamento di paradigma nel modello di calcolo della blockchain, dal tradizionale registro di consenso a sequenza completa a un ambiente di esecuzione distribuito ad alte prestazioni, prevedibile e dispacciabile. Questo non è solo un recupero dell'efficienza del cloud computing Web2, ma anche una profonda concezione della forma definitiva di "computer blockchain". La selezione di percorsi paralleli per diverse catene pubbliche determinerà anche il limite superiore sopportabile dei loro futuri ecosistemi applicativi, nonché la loro competitività di base in scenari come l'agente AI, i giochi a catena e il trading ad alta frequenza on-chain.

In quarto luogo, vengono spiegati i due percorsi principali: Monad vs MegaETH

Tra i molteplici percorsi di evoluzione del calcolo parallelo, i due principali percorsi tecnici con il maggior focus, la voce più alta e la narrazione più completa nel mercato attuale sono senza dubbio la "costruzione di una catena di calcolo parallelo da zero" rappresentata da Monad e la "rivoluzione parallela all'interno dell'EVM" rappresentata da MegaETH. Queste due direzioni non sono solo le direzioni di ricerca e sviluppo più intense per gli attuali ingegneri primitivi crittografici, ma anche i simboli polari più decisivi nell'attuale corsa alle prestazioni dei computer Web3. La differenza tra i due risiede non solo nel punto di partenza e nello stile dell'architettura tecnica, ma anche negli oggetti ecologici che servono, nel costo della migrazione, nella filosofia di esecuzione e nel futuro percorso strategico dietro di essi. Esse rappresentano una competizione paradigmatica parallela tra "ricostruzionismo" e "compatibilismo" e hanno profondamente influenzato l'immaginazione del mercato sulla forma finale delle catene ad alte prestazioni.

Monad è un "fondamentalista computazionale" in tutto e per tutto, e la sua filosofia di progettazione non è progettata per essere compatibile con gli EVM esistenti, ma piuttosto per ridefinire il modo in cui i motori di esecuzione blockchain funzionano in modo inventivo, traendo ispirazione dai moderni database e dai sistemi multi-core ad alte prestazioni. Il suo sistema tecnologico di base si basa su meccanismi maturi nel campo dei database come il controllo della concorrenza ottimistica, la pianificazione DAG delle transazioni, l'esecuzione fuori ordine e l'esecuzione in pipeline, con l'obiettivo di aumentare le prestazioni di elaborazione delle transazioni della catena nell'ordine di milioni di TPS. Nell'architettura Monad, l'esecuzione e l'ordinamento delle transazioni sono completamente disaccoppiati e il sistema prima costruisce un grafico delle dipendenze delle transazioni, quindi lo passa allo scheduler per l'esecuzione parallela. Tutte le transazioni vengono trattate come unità atomiche di transazioni, con set di lettura/scrittura espliciti e snapshot dello stato, e le utilità di pianificazione vengono eseguite in modo ottimistico in base ai grafici delle dipendenze, eseguendo il rollback e la riesecuzione quando si verificano conflitti. Questo meccanismo è estremamente complesso in termini di implementazione tecnica, richiedendo la costruzione di uno stack di esecuzione simile a quello di un moderno gestore di transazioni di database, nonché l'introduzione di meccanismi come il caching multilivello, il prefetching, la validazione parallela, ecc., per comprimere la latenza del commit dello stato finale, ma può teoricamente spingere il limite di throughput ad altezze che non sono immaginate dalla catena corrente.

Ancora più importante, Monad non ha rinunciato all'interoperabilità con l'EVM. Utilizza un livello intermedio simile a "Solidity-Compatible Intermediate Language" per supportare gli sviluppatori nella scrittura di contratti nella sintassi Solidity e allo stesso tempo eseguire l'ottimizzazione del linguaggio intermedio e la pianificazione della parallelizzazione nel motore di esecuzione. Questa strategia di progettazione di "compatibilità di superficie e refactoring del fondo" non solo mantiene la cordialità degli sviluppatori ecologici di Ethereum, ma libera anche il potenziale di esecuzione sottostante nella massima misura, che è una tipica strategia tecnica di "ingoiare l'EVM e poi decostruirlo". Ciò significa anche che, una volta lanciato, Monad non solo diventerà una catena sovrana con prestazioni estreme, ma anche un livello di esecuzione ideale per le reti rollup di livello 2 e persino un "core pluggable ad alte prestazioni" per altri moduli di esecuzione a catena a lungo termine. Da questo punto di vista, Monad non è solo un percorso tecnico, ma anche una nuova logica di progettazione della sovranità del sistema, che sostiene la "modularizzazione-prestazioni-riusabilità" del livello di esecuzione, così da creare un nuovo standard per il calcolo collaborativo inter-chain.

A differenza della posizione di Monad "new world builder", MegaETH è un tipo di progetto completamente opposto, che sceglie di partire dal mondo esistente di Ethereum e ottenere un aumento significativo dell'efficienza di esecuzione con costi di modifica minimi. MegaETH non stravolge la specifica EVM, ma piuttosto cerca di integrare le capacità di calcolo parallelo nel motore di esecuzione degli EVM esistenti, creando una versione futura dell'"EVM multi-core". La logica risiede in un refactoring completo dell'attuale modello di esecuzione delle istruzioni EVM con funzionalità come l'isolamento a livello di thread, l'esecuzione asincrona a livello di contratto e il rilevamento dei conflitti di accesso allo stato, consentendo l'esecuzione simultanea di più contratti intelligenti nello stesso blocco e infine l'unione delle modifiche di stato. Questo modello richiede agli sviluppatori di ottenere significativi guadagni in termini di prestazioni dallo stesso contratto distribuito sulla catena MegaETH senza modificare i contratti Solidity esistenti, utilizzando nuovi linguaggi o toolchain. Questo percorso di "rivoluzione conservativa" è estremamente attraente, soprattutto per l'ecosistema Ethereum L2, in quanto fornisce un percorso ideale per aggiornamenti delle prestazioni indolori senza la necessità di migrare la sintassi.

La svolta principale di MegaETH risiede nel suo meccanismo di pianificazione multi-thread VM. Gli EVM tradizionali utilizzano un modello di esecuzione stacked a thread singolo, in cui ogni istruzione viene eseguita in modo lineare e gli aggiornamenti di stato devono avvenire in modo sincrono. MegaETH rompe questo schema e introduce uno stack di chiamate asincrone e un meccanismo di isolamento del contesto di esecuzione, in modo da ottenere l'esecuzione simultanea di "contesti EVM concorrenti". Ogni contratto può richiamare la propria logica in un thread separato e tutti i thread rileveranno e convergeranno uniformemente lo stato attraverso il livello di commit parallelo quando lo stato viene infine inviato. Questo meccanismo è molto simile al modello multithreading JavaScript dei browser moderni (Web Workers + Shared Memory + Lock-Free Data), che mantiene il determinismo del comportamento del thread principale e introduce un meccanismo di pianificazione ad alte prestazioni che è asincrono in background. In pratica, questo design è anche molto amichevole per i costruttori di blocchi e i ricercatori e può ottimizzare l'ordinamento della mempool e i percorsi di cattura MEV secondo la strategia parallela, formando un ciclo chiuso di vantaggi economici sul livello di esecuzione.

Ancora più importante, MegaETH sceglie di essere profondamente legato all'ecosistema Ethereum e il suo principale punto di approdo in futuro sarà probabilmente una rete EVM L2 Rollup, come Optimism, Base o Arbitrum Orbit chain. Una volta adottato su larga scala, può ottenere un miglioramento delle prestazioni di quasi 100 volte rispetto allo stack tecnologico Ethereum esistente senza modificare la semantica del contratto, il modello di stato, la logica del gas, i metodi di invocazione, ecc., il che lo rende una direzione di aggiornamento tecnologico interessante per i conservatori EVM. Il paradigma di MegaETH è: finché stai ancora facendo cose su Ethereum, allora lascerò che le tue prestazioni di calcolo salgano alle stelle. Dal punto di vista del realismo e dell'ingegneria, è più facile da implementare rispetto a Monad, ed è più in linea con il percorso iterativo dei principali progetti DeFi e NFT, il che lo rende un candidato che ha maggiori probabilità di ricevere un sostegno ecologico a breve termine.

In un certo senso, le due strade di Monad e MegaETH non sono solo due implementazioni di percorsi tecnologici paralleli, ma anche un classico confronto tra "refactoring" e "compatibilità" nel percorso di sviluppo della blockchain: la prima persegue una svolta di paradigma e ricostruisce tutta la logica dalle macchine virtuali alla gestione dello stato sottostante per ottenere prestazioni e plasticità architetturale definitive; Quest'ultimo persegue l'ottimizzazione incrementale, spingendo al limite i sistemi tradizionali nel rispetto dei vincoli ecologici esistenti, minimizzando così i costi di migrazione. Non ci sono vantaggi o svantaggi assoluti tra i due, ma servono diversi gruppi di sviluppatori e visioni dell'ecosistema. Monad è più adatto per la creazione di nuovi sistemi da zero, giochi a catena che perseguono un throughput estremo, agenti di intelligenza artificiale e catene di esecuzione modulari. MegaETH, d'altra parte, è più adatto per progetti L2, progetti DeFi e protocolli infrastrutturali che vogliono ottenere aggiornamenti delle prestazioni con modifiche di sviluppo minime.

Sono come treni ad alta velocità su un nuovo binario, ridefiniti dal binario, dalla rete elettrica alla carrozzeria dell'auto, solo per raggiungere una velocità e un'esperienza senza precedenti; Un altro esempio è l'installazione di turbine sulle autostrade esistenti, il miglioramento della programmazione delle corsie e della struttura del motore, consentendo ai veicoli di andare più veloci senza lasciare la rete stradale familiare. Le due cose potrebbero finire allo stesso modo: nella prossima fase delle architetture blockchain modulari, Monad potrebbe diventare un modulo "execution-as-a-service" per i Rollup, e MegaETH potrebbe diventare un plugin di accelerazione delle prestazioni per i L2 mainstream. I due potrebbero eventualmente convergere per formare le due ali del motore di esecuzione distribuita ad alte prestazioni nel futuro mondo Web3.

5. Opportunità e sfide future del calcolo parallelo

Man mano che il calcolo parallelo passa dalla progettazione cartacea all'implementazione on-chain, il potenziale che sblocca sta diventando più concreto e misurabile. Da un lato, vediamo che nuovi paradigmi di sviluppo e modelli di business hanno iniziato a ridefinire le "prestazioni on-chain": logiche di gioco a catena più complesse, ciclo di vita degli agenti AI più realistico, protocolli di scambio dati più in tempo reale, esperienze interattive più immersive e persino sistemi operativi Super App collaborativi on-chain stanno tutti cambiando da "possiamo farlo" a "quanto può essere buono". D'altra parte, ciò che guida davvero la transizione al calcolo parallelo non è solo il miglioramento lineare delle prestazioni del sistema, ma anche il cambiamento strutturale dei confini cognitivi degli sviluppatori e dei costi di migrazione ecologica. Così come l'introduzione del meccanismo di contratto Turing-complete da parte di Ethereum ha dato vita all'esplosione multidimensionale di DeFi, NFT e DAO, la "ricostruzione asincrona tra stato e istruzioni" portata avanti dal calcolo parallelo sta anche dando vita a un nuovo modello di mondo on-chain, che non è solo una rivoluzione nell'efficienza di esecuzione, ma anche un focolaio di innovazione nella fissione nella struttura del prodotto.

Innanzitutto, dal punto di vista delle opportunità, il vantaggio più diretto è l'"innalzamento del tetto delle candidature". La maggior parte delle attuali applicazioni DeFi, di gioco e social sono limitate da colli di bottiglia statali, costi del gas e latenza e non possono realmente trasportare interazioni ad alta frequenza sulla catena su larga scala. Prendendo come esempio i giochi a catena, il GameFi con feedback di movimento reale, sincronizzazione del comportamento ad alta frequenza e logica di combattimento in tempo reale quasi non esiste, perché l'esecuzione lineare degli EVM tradizionali non può supportare la conferma della trasmissione di dozzine di cambiamenti di stato al secondo. Con il supporto del calcolo parallelo, attraverso meccanismi come i DAG transazionali e i contesti asincroni a livello di contratto, è possibile costruire catene ad alta concorrenza e garantire risultati di esecuzione deterministici attraverso la coerenza degli snapshot, in modo da ottenere una svolta strutturale nel "motore di gioco on-chain". Analogamente, anche l'implementazione e il funzionamento degli agenti di IA saranno notevolmente migliorati dal calcolo parallelo. In passato, tendevamo a eseguire gli agenti di intelligenza artificiale off-chain e a caricare i risultati del loro comportamento solo su contratti on-chain, ma in futuro l'on-chain può supportare la collaborazione asincrona e la condivisione dello stato tra più entità di intelligenza artificiale attraverso la pianificazione parallela delle transazioni, in modo da realizzare veramente la logica autonoma in tempo reale dell'agente on-chain. Il calcolo parallelo sarà l'infrastruttura per questo "contratto guidato dal comportamento", guidando il Web3 da una "transazione come risorsa" a un nuovo mondo di "interazione come agente".

In secondo luogo, anche la toolchain di sviluppo e il livello di astrazione della macchina virtuale sono stati rimodellati strutturalmente a causa della parallelizzazione. Il tradizionale paradigma di sviluppo di Solidity si basa su un modello di pensiero seriale, in cui gli sviluppatori sono abituati a progettare la logica come un cambiamento di stato a thread singolo, ma nelle architetture di calcolo parallelo, gli sviluppatori saranno costretti a pensare ai conflitti di set di lettura/scrittura, alle politiche di isolamento dello stato, all'atomicità delle transazioni e persino a introdurre modelli architettonici basati su code di messaggi o pipeline di stato. Questo salto nella struttura cognitiva ha anche dato vita alla rapida ascesa di una nuova generazione di catene di strumenti. Ad esempio, i framework di smart contract paralleli che supportano le dichiarazioni di dipendenza transazionale, i compilatori di ottimizzazione basati su IR e i debugger concorrenti che supportano la simulazione di snapshot delle transazioni diventeranno tutti focolai di esplosioni dell'infrastruttura nel nuovo ciclo. Allo stesso tempo, la continua evoluzione delle blockchain modulari ha portato anche un eccellente percorso di atterraggio per il calcolo parallelo: Monad può essere inserito in L2 Rollup come modulo di esecuzione, MegaETH può essere implementato come sostituto EVM per le catene mainstream, Celestia fornisce il supporto del livello di disponibilità dei dati e EigenLayer fornisce una rete di validatori decentralizzata, formando così un'architettura integrata ad alte prestazioni dai dati sottostanti alla logica di esecuzione.

Tuttavia, l'avanzamento del calcolo parallelo non è una strada facile e le sfide sono ancora più strutturali e difficili da rosicchiare rispetto alle opportunità. Da un lato, le principali difficoltà tecniche risiedono nella "garanzia di coerenza della concorrenza statale" e nella "strategia di gestione dei conflitti di transazione". A differenza dei database off-chain, l'on-chain non può tollerare un grado arbitrario di rollback delle transazioni o di retrazione dello stato, ed eventuali conflitti di esecuzione devono essere modellati in anticipo o controllati con precisione durante l'evento. Ciò significa che l'utilità di pianificazione parallela deve disporre di forti funzionalità di costruzione del grafico delle dipendenze e di previsione dei conflitti e allo stesso tempo progettare un meccanismo di tolleranza agli errori di esecuzione ottimistico efficiente, altrimenti il sistema è soggetto a "tempesta di tentativi di errore simultaneo" in condizioni di carico elevato, che non solo aumenta ma diminuisce e causa persino l'instabilità della catena. Inoltre, l'attuale modello di sicurezza dell'ambiente di esecuzione multi-thread non è ancora stato completamente stabilito, come la precisione del meccanismo di isolamento dello stato tra i thread, il nuovo utilizzo di attacchi di re-entrancy in contesti asincroni e l'esplosione di gas di chiamate di contratto cross-threaded, che sono tutti nuovi problemi che devono essere risolti.

Le sfide più insidiose derivano da aspetti ecologici e psicologici. Se gli sviluppatori sono disposti a migrare verso il nuovo paradigma, se sono in grado di padroneggiare i metodi di progettazione dei modelli paralleli e se sono disposti a rinunciare ad una certa leggibilità e verificabilità contrattuale per ottenere vantaggi in termini di prestazioni sono la chiave per stabilire se il calcolo parallelo può formare energia potenziale ecologica. Negli ultimi anni, abbiamo visto un certo numero di catene con prestazioni superiori ma prive di supporto per gli sviluppatori cadere gradualmente in silenzio, come NEAR, Avalanche e persino alcune catene Cosmos SDK che superano di gran lunga l'EVM, e la loro esperienza ci ricorda che senza sviluppatori non c'è ecosistema; Senza ecologia, non importa quanto siano buone le prestazioni, è solo un castello in aria. Pertanto, i progetti di calcolo parallelo non dovrebbero solo realizzare il motore più potente, ma anche realizzare il percorso di transizione ecologica più delicato, in modo che "le prestazioni siano il pronto all'uso" piuttosto che "le prestazioni siano la soglia cognitiva".

In definitiva, il futuro del calcolo parallelo è sia un trionfo per l'ingegneria dei sistemi che un test per l'eco-design. Ci costringerà a riesaminare "qual è l'essenza della catena": è una macchina di regolamento decentralizzata o un orchestratore statale in tempo reale distribuito a livello globale? In quest'ultimo caso, le capacità di throughput statale, concorrenza delle transazioni e reattività ai contratti, che in precedenza erano considerate "dettagli tecnici della catena", diventeranno alla fine gli indicatori primari che definiscono il valore della catena. Il paradigma di calcolo parallelo che completerà veramente questa transizione diventerà anche la primitiva dell'infrastruttura più core e più composta in questo nuovo ciclo, e il suo impatto andrà ben oltre un modulo tecnico e potrebbe costituire un punto di svolta nel paradigma di calcolo complessivo del Web3.

6. Conclusione: il calcolo parallelo è il percorso migliore per la scalabilità nativa Web3?

Di tutti i percorsi che esplorano i confini delle prestazioni Web3, il calcolo parallelo non è il più facile da implementare, ma potrebbe essere il più vicino all'essenza della blockchain. Non migra off-chain, né sacrifica la decentralizzazione in cambio del throughput, ma cerca di ricostruire il modello di esecuzione stesso nell'atomicità e nel determinismo della catena, dal livello di transazione, dal livello di contratto e dal livello di macchina virtuale alla radice del collo di bottiglia delle prestazioni. Questo metodo di scalabilità "nativo della catena" non solo mantiene il modello di fiducia di base della blockchain, ma riserva anche un terreno di prestazioni sostenibili per applicazioni on-chain più complesse in futuro. La sua difficoltà sta nella struttura, e il suo fascino sta nella struttura. Se il refactoring modulare è l'"architettura della catena", allora il refactoring del calcolo parallelo è "l'anima della catena". Questa potrebbe non essere una scorciatoia per lo sdoganamento, ma è probabile che sia l'unica soluzione positiva sostenibile nell'evoluzione a lungo termine del Web3. Stiamo assistendo a una transizione architetturale da CPU single-core a sistemi operativi multi-core/threaded e l'aspetto di sistemi operativi nativi Web3 potrebbe essere nascosto in questi esperimenti paralleli in-chain.

Mostra originale